一、引言

在摩尔定律的指导下,集成电路的制造工艺一直在不断向前演进。得益于智能手机的流行,人们对芯片制造工艺技术节点有所耳闻。例如90nm、28nm、14nm、7nm等等,要想了解这些技术节点的真正含义,首先要做以下剖析:

为什么这个尺寸重要呢。因为晶体管的作用,是把电子从一端源极,通过一段沟道,送到另一端漏极,这个过程完成了之后,信息的传递就完成了。因为电子的速度是有限的,在现代晶体管中,一般都是以饱和速度运行,所以需要的时间基本就由这个沟道的长度来决定。越短,就越快。这个沟道的长度,和前面说的晶体管尺寸,大体上可以认为是一致的。但是二者有区别,沟道长度是一个晶体管物理的概念,而用于技术节点的那个尺寸,是制造工艺的概念,二者相关,但不相等。

在微米时代,一般这个技术节点的数字越小,晶体管的尺寸也越小,沟道长度也就越小。但是在22nm节点之后,晶体管的实际尺寸,或者说沟道的实际长度,是大于这个数字的。比方说,英特尔的14nm的晶体管,沟道长度其实是20nm左右。

根据以上介绍,晶体管微缩过程中涉及到三个问题,分别是:

第一,为什么要把晶体管的尺寸缩小,是按照何等比例缩小,引申为晶体管微缩有什么好处?

第二,为什么技术节点的数字不能等同于晶体管的实际尺寸?或者说,在晶体管的实际尺寸并没有按比例缩小的情况下,为何要宣称是新一代的技术节点?引申为晶体管微缩有哪些技术难点?

第三,晶体管微缩的技术节点发展历程是怎样的?每一代都有怎样的技术进步?

二、工艺节点演变路径

2.1 缩小晶体管尺寸

晶体管尺寸越小,速度就越快。这个快是可以直接解释为基于晶体管的集成电路芯片的性能提升。尺寸缩小之后,集成度(单位面积的晶体管数量)大幅提升。一是可以增加芯片的功能,二是集成度提升的直接结果是成本的下降。这也是为什么半导体行业50年来一如既往地追求摩尔定律的原因,因为如果达不到这个节点,自家产品成本就会高于能达到同标准的友商,距离淘汰就不远了。

晶体管微缩可以降低单个晶体管的功耗。根据微缩的规则,会降低整体芯片的供电电压,进而降低功耗。但有个例外,就是从物理原理上说,单位面积的功耗并不降低。因此就成为晶体管微缩的一个很严重的问题,因为理论上的计算是理想情况,实际上,不仅功耗不降低,反而是随着集成度的提高而升高。

在2000年的时候,人们已经预测,根据摩尔定律,如果没有任何技术进步的话,晶体管缩小到2010年时,其功耗密度可以达到火箭发动机的水平,这样的芯片当然是不可能正常工作的。即便达不到该水平,太高的温度也会影响晶体管的性能。以上是晶体管微缩的主要诱因。可以看出,都是重量级的性能提升、功能改善、成本降低的方法,所以业界才会一直坚持到现在。

那么晶体管是怎样缩小的呢?物理原理是恒定电场,因为晶体管的物理学通俗地说,是电场决定的,所以只要电场不变,晶体管的模型就不需要改变,这种方式被证明效果最佳,被称为Dennard Scaling,提出者是IBM。

电场等于电压除以尺寸。既然要缩小尺寸,就要等比降低电压。如何缩小尺寸。简单将面积缩小到原来的一半。面积等于尺寸的平方,因此尺寸就缩小大约0.7。看一下晶体管技术节点的数字:130nm、90nm、65nm、45nm、32nm、22nm、14nm、10nm、7nm、5nm,会发现它们是一个大约为0.7为比的等比数列,就是这个原因。当然,前面说过,在现在,这只是一个命名的习惯,跟实际尺寸已经有很大差距了。

2.2 节点的数字不能等同于晶体管的实际尺寸

为什么现在的技术节点不再直接反应晶体管的实际尺寸了呢?原因也很简单,因为无法做到这个程度的微缩了。

首先,原子尺度的计量单位是埃(Å),为0.1nm。10nm的沟道长度,也就只有不到100个硅原子而已。晶体管本来的物理模型这样的:用量子力学的能带理论计算电子的分布,用经典的电流理论计算电子的输运。电子在分布确定之后,仍然被当作一个粒子来对待,而不是考虑它的量子效应。因为尺寸大,所以不需要。但是越小,就越不行了,就需要考虑各种复杂的物理效应,晶体管的电流模型也就不再适用。

其次,即使用经典的模型,性能上也出了问题,这个叫做短沟道效应(Short-channel effects),其结果是损害晶体管的性能。短沟道效应其实很好理解,通俗地讲,晶体管是一个三个端口的开关。前面已经说过,其工作原理是把电子从一端(源极)输运到另一端(漏极),这是通过沟道进行的;另外还有一个端口(栅极)的作用是,决定沟道是否打开。以上操作都是通过在各端口上施加特定电压来完成的。

评估晶体管性能的关键点在于,必须要打得开,也要关得紧。短沟道器件,打得开没问题,但是关不紧。原因就是尺寸太小,内部有很多电场上的互相干扰,以前都是可以忽略不计的,现在则会导致栅极电场不能发挥全部作用,因此关不紧。关不紧的后果就是有漏电流,简单地说就是出现不需要、浪费的电流。这部分电流可不能小看,因为此时晶体管是在休息,没有做任何事情,却在白白地耗电。目前,集成电路中的这部分漏电流导致的能耗,已经占到了总能耗的近一半,所以也是目前晶体管设计和电路设计改进的一个主攻方向。

最后,芯片制造也越来越难做到那么小的尺寸。决定制造工艺的最小尺寸的设备,叫做光刻机。它的主要功能是,把预先印制好的电路设计,像洗照片一样洗到晶圆表面上去,在我看来就是一种Bug级的存在,因为吞吐率非常地高。否则那么复杂的集成电路,如何才能制造出来呢。比如英特尔的处理器,据说需要40多张不同的设计模板,先后不断地曝光,才能完成整个处理器设计的印制。

但是光刻机,顾名思义,是用光的,当然不是可见光,但总之是光。而稍有常识就会知道,所有用光的东西,都有一个本质的问题,就是衍射。光刻机不例外。因为这个问题的制约,任何一台光刻机所能刻制的最小尺寸,基本上与它所用的光源的波长成正比。波长越小,尺寸也就越小,这个道理是很简单的。

业界十多年来在光刻技术上投入了巨资,先后开发了各种魔改级别的技术,诸如浸入式光刻(把光程放在某种液体里,因为光的折射率更高,而最小尺寸反比于折射率)、相位掩模(通过180度反向的方式来让产生的衍射互相抵消,提高精确度)等等,就这样一直撑到了现在,支持了60nm以来的所有技术节点的进步。

高端光刻机的光源,是世界级的工业难题。极紫外(EUV)光刻机的光源波长降到了13nm。但是,因为在这个波长,已经没有合适的介质可以用来折射光并构成所必须的光路了,因此这个技术里面的光学设计,全部是反射,而在如此高的精度下,设计如此复杂的反射光路,本身就是难以想象的技术难题。这还不算什么,此问题已经能被克服了。最难的还是光源,虽然可以产生所需的光线,但是强度远低于工业生产的需求,造成EUV光刻机的晶圆良率若达不到要求,换言之拿来用就会赔本。一台EUV光刻机,就是上亿美元。由于以上三个原因,其实很早开始就导致晶体管的尺寸缩小进入了深水区,越来越难。到了22nm之后,芯片已经无法按比例缩小了。因此,就没有再追求一定要缩小,反而是采用了更加优化的晶体管设计,配合上CPU架构上的多核多线程等一系列技术,继续为消费者提供相当于更新换代了的产品性能。因为这个原因,技术节点的数字仍然在缩小,但是已然不再等同于晶体管的尺寸,而是代表一系列构成这个技术节点的指标的技术和工艺的总和。

2.3 晶体管微缩过程中面临的问题

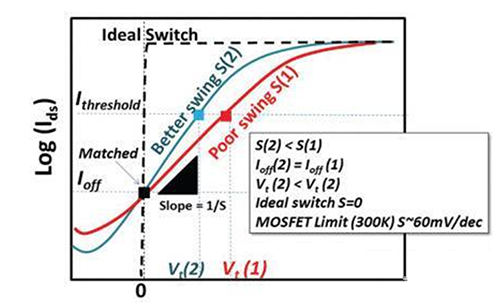

技术节点的缩小过程中,晶体管的设计是如何发展的?首先要搞清楚,晶体管设计的思路是什么。无非是两点:一是提升开关响应速度,二是降低漏电流。为了讲清楚这个问题,最好的方法是看下晶体管的漏电流-栅电压的关系图,比如下面这种:横轴代表栅电压,纵轴代表漏电流,且纵轴一般是对数坐标。

前面说过,栅电压控制晶体管的开关。可以看出,最好的晶体管,是那种能够在很小的栅电压变化内,一下子就从完全关闭(漏电流为0),变成完全打开(漏电流达到饱和值),也就是虚线。这个性质有多方面的好处,接下来再说。显然这种晶体管不存在于这个星球上。

原因是,在经典的晶体管物理理论下,衡量这个开关响应能力的标准,叫做亚阈摆幅(Subthreshold Swing),有一个极限值,约为60 mV/dec。降低这个值,和降低漏电流、提升工作电流(提高速度)、降低功耗等要求,是等同的,因为这个值越低,在同样的电压下,漏电流就越低。而为了达到同样的工作电流,需要的电压就越低,这样等同于降低了功耗。所以说这个值是晶体管设计里面最重要的指标,并不过分。

围绕这个指标,以及背后的晶体管性能设计的几个目标,大家都做了哪些事情呢。

先看工业界,毕竟实践是检验真理的唯一标准。下面的描述,和技术节点的对应有一定出路:65nm 引入Ge strained 的沟道。strain原理是通过在适当的地方掺杂一点点的锗到硅里面去,锗和硅的晶格常数不同,因此会导致硅的晶格形状改变。但根据能带理论,这个改变可以在沟道的方向上提高电子迁移率,而迁移率高,就会提高晶体管的工作电流。而在实际中,人们发现,这种方法对于空穴型沟道的晶体管(p-mos),比对电子型沟道的晶体管(n-mos),更加有效。

2.4 里程碑的突破,45nm引入高k绝缘层

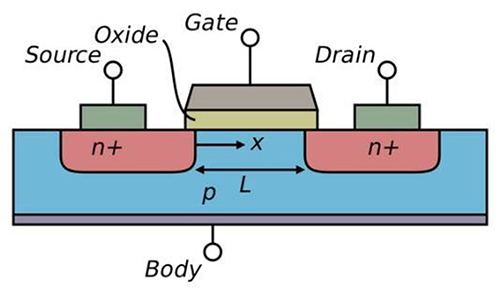

45nm技术节点引入了高k值绝缘层/金属栅极的配置。这其实是两项技术,但其实都是为了解决同一个问题:在很小的尺寸下,如何保证栅极有效的工作。前面没有细说晶体管的结构,见下图。

以上是一个最基本的晶体管结构示意图,现在的晶体管早就不长这样了,但是任何半导体物理都是从这儿开始讲起的,所以这是“标准版”的晶体管,又被称为体硅(bulk)晶体管。Gate是栅极,还有一个Oxide(绝缘层),却是晶体管所有的构件中最关键的一个。它的作用是隔绝栅极和沟道。因为栅极开关沟道,是通过电场进行的,电场的产生又是通过在栅极上加一定的电压来实现的,但是欧姆定律告诉我们,有电压就有电流。如果有电流从栅极流进了沟道,那么还谈什么开关,早就漏了。所以,需要绝缘层。

为什么是Oxide而不是insulator。因为最早的绝缘层就是和硅非常自然地共处的二氧化硅,其相对介电常数(衡量绝缘性的指标,越高,对晶体管性能来说越好)约是3.9。一个好的绝缘层是晶体管的生命线。但需要说明的是,硅天然就具有这么一个性能超级好的绝缘层,对于半导体工业来说,是一件有历史意义的幸运的事情。有人曾经感慨,上帝都在帮助人类发明集成电路,首先给了那么多的沙子(硅晶圆的原料),又给了一个完美的天然绝缘层。所以至今,硅极其难被取代。一个重要原因就是,作为制造晶体管的材料,其综合性能实在是太完美了。

二氧化硅虽好,在晶体管尺寸缩小到一定限度时,也会出现了问题。缩小尺寸的过程中,电场强度是保持不变的,在这样的情况下,从能带的角度看,因为电子的波动性,如果绝缘层很窄很窄的话,那么有一定的几率电子会发生隧穿效应(tunneling effect)而越过绝缘层的能带势垒,产生漏电流。可以想象为穿过一堵比自己高的墙。这个电流的大小和绝缘层的厚度,以及绝缘层的势垒高度成负相关。因此厚度越小,势垒越低,漏电流越大,对晶体管越不利。

但是在另一方面,晶体管的开关性能、工作电流等等,都需要拥有一个很大的绝缘层电容。实际上,如果这个电容无限大的话,会达到理想化的60 mV/dec的SS极限指标。这里说的电容都是指单位面积的电容。这个电容等于介电常数除以绝缘层的厚度。显然,厚度越小,介电常数越大,对晶体管越有利。

可以看出,已经出现了一对设计目标上的矛盾,那就是绝缘层的厚度要不要继续缩小。实际上在这个节点之前,二氧化硅已经缩小到了不到2nm的厚度,也就是十几个原子层的厚度,漏电流的问题已经取代了性能的问题,成为头号大敌。于是聪明绝顶的人类,开始想办法。人类很贪心的,既不愿意放弃大电容的性能增强,又不愿意冒漏电的风险。于是人类说,如果有一种材料,介电常数很高,同时能带势垒也很高,那么是不是就可以在厚度不缩小的情况下(保护漏电流),继续提升电容(提高开关性能)。

于是大家就开始找,找了许多种奇奇怪怪的材料,终于最后经过验证,确定使用一种名为HfO2的材料。这个就叫做high-k,这里的k是相对介电常数(相对于二氧化硅的而言)。当然,这个工艺的复杂程度,远远超过描述的这么简单。具备high-k性质的材料很多,但是最终被采用的材料,一定要具备许多优秀的电学性质。

鉴于二氧化硅真的是一项非常完美的晶体管绝缘层材料,而且制造工艺流程和集成电路的其它制造步骤可以方便地整合,所以找到这样一项各方面都符合半导体工艺制造的要求的高性能新的绝缘层材料,是一件了不起的成就。

至于金属栅极,是与high-k配套的一项技术。在晶体管的最早期,栅极是用铝制作,后来经过发展,改用重掺多晶硅制作,因为工艺简单,性能好。到了high-k这里,大家发现,high-k材料有两个副作用,一是会莫名其妙地降低工作电流,二是会改变晶体管的阈值电压。阈值电压就是把晶体管的沟道打开所需要的最小电压值,这个值是非常重要的晶体管参数。

这个原理不细说了,主要原因是,high-k材料会降低沟道内的载流子迁移率,并且影响在界面上的费米能级的位置。载流子迁移率越低,工作电流就越低,而所谓的费米能级,是从能带理论的图像上来解释半导体电子分布的一种分析方法。简单来说,它的位置会影响晶体管的阈值电压。这两个问题的产生,都和high-k材料内部的偶极子分布有关。偶极子是一端正电荷一端负电荷的一对电荷系统,可以随着外加电场的方向而改变自己的分布,high-k材料的介电常数之所以高的原因,就跟内部的偶极子有很大关系。所以这是一把双刃剑。

于是人们又想,就想到了用金属做栅极,因为金属有一个效应叫做镜像电荷,可以中和掉high-k材料的绝缘层里的偶极子对沟道和费米能级的影响。这样一来就两全其美。至于这种或这几种金属究竟是什么,除了掌握技术的那几家企业之外,外界没有人知道,是商业机密。于是摩尔定律再次胜利。

32nm节点采用了第二代的high-k绝缘层/金属栅工艺。因为45nm英特尔取得了巨大的成功(在很多晶体管、微处理器的发展图上,45nm这一代的晶体管,会在功耗、性能等方面突然出现一个较大的进步标志),32nm 时候继续在基础上改换更好的材料,继续了缩小尺寸的老路。当然,前一代的Ge strain工艺也是继续使用的。

2.5 聪明的IBM,天才的英特尔

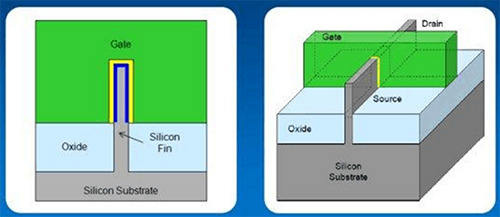

22nm FinFET(英特尔称为3D三栅极晶体管)这一代的晶体管,在架构上进行了一次变革。变革的最早设计可以追溯到美国加州大学伯克利分校的胡正明教授2000年左右提出的三栅极和环栅晶体管物理模型,后来被英特尔变为了现实。

英特尔推出了3D三栅极晶体管,其中晶体管沟道增加到第三维度。电流是从沟道的三面(顶部、左侧和右侧)来控制的,而不是像传统平面晶体管一样,只从顶部控制。最终的结果就是能够更好地控制晶体管、最大程度利用晶体管开启状态时的电流,并且在关闭状态时最大程度减少漏电流。

直观地说,如果看回前面的那张“标准版”的晶体管结构图的话,在尺寸很短的晶体管里面,因为短沟道效应,漏电流是比较严重的。而大部分的漏电流,是通过沟道下方的那片区域流通的。沟道在图上并没有标出来,是位于氧化绝缘层以下、硅晶圆表面的非常非常薄(1~2 nm)的一个窄窄的薄层。沟道下方的区域被称为耗尽层,就是大部分的浅色区域。

于是有人就开始想啊,既然电子是在沟道中运动,那么我为何非要在沟道下面留有这么一大片耗尽层呢。当然这是有原因的,因为物理模型需要这片区域来平衡电荷。但是在短沟道器件里面,没有必要非要把耗尽层和沟道放在一起,等着漏电流白白地流过去。于是有人(IBM)开了一个脑洞:把这部分硅直接拿掉,换成绝缘层,绝缘层下面才是剩下的硅,这样沟道就和耗尽层分开了,因为电子来源于两极,但是两极和耗尽层之间,被绝缘层隔开了,这样除了沟道之外,就不会漏电了。这个叫做SOI(绝缘层上硅),虽然没有成为主流,但是因为有其优势,所以现在还有制造厂在搞。

有人(英特尔)又想了,既然都是拿掉耗尽层的硅,插入一层氧化层,那么为什么非要放上一堆没用的硅在下面,直接在氧化层底下,再弄一个栅极,两边夹着沟道,岂不是更好。但英特尔还觉得不够,又想,既然如此,有什么必要非得把氧化层埋在硅里面。把硅弄出来,周围像三明治一样地被包裹上绝缘层,外面再放上栅极,岂不是更加优化。于是就有了FinFET。FinFET胜出在于,不仅大大降低了漏电流,而且因为在硅鳍状物(Fin)三面的每一面安装一个栅极,这些栅极都是连在一起的,因此等于大大地增加了前面说过的那个绝缘层电容,也就是大大地提升了晶体管的开关性能。所以又是一次革命性的进步。

这个设计其实不难想到,难的是如何能做到。为什么呢。因为竖起来的那一部分硅,也就是用作沟道的硅,太薄了,只有不到10nm,不仅远小于晶体管的最小尺寸,也远小于最精密的光刻机所能刻制的最小尺寸。于是如何把这个Fin给弄出来,还得弄好,成了真正的难题。

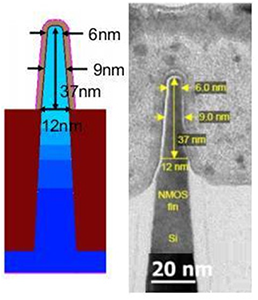

英特尔的做法是很聪明的,解释起来需要很多张工艺流程图。但是基本原理是,这部分硅不是光刻出来的,而是长出来的。它先用普通精度的光刻蚀出一堆架子,然后再沉淀一层硅,在架子的边缘就会长出一层很薄的硅,然后再用选择性的刻蚀把多余的材料弄走,剩下的就是这些立着的、超薄的硅鳍状物了。当时说出这套方法的时候,彻底绝了。14nm 继续FinFET。14nm晶体管的SEM横截面图,大家感受一下,Fin的宽度只有平均9nm。当然了,在所有的后代的技术节点中,前代的技术也是继续整合采用的。所以现在业界和研究中,一般听到的晶体管,都被称作high-k/metal gate Ge-strained 14 nm FinFET,它整合了多年的技术精华。

三、结语

技术节点不能进步,是不是一定就是坏事。28nm 这个节点,其实不属于前面提到的标准的dennard scaling 的一部分,但是这个技术节点,直到现在,仍然在半导体制造业界占据了很大的一块市场份额。台积电、中芯国际等这样的代工厂,都是在28nm上玩得很转的。为何,因为这个节点被证明是一个在成本、性能、需求等多方面达到了比较优化的组合的一个节点,很多芯片产品,并不需要使用过于昂贵的FinFET技术,28nm完全能够满足自己的需求。

但是有一些产品,比如主流的CPU、GPU、FPGA、Memory等,其性能的提升有相当一部分是来自于芯片制造工艺的进步。所以再往后如何继续提升这些产品的性能,是很多人心中的问号,也是新的机会。

文章来源:ICPMS冷知识

联系人:袁经理

手机:051683539599

电话:051683539599

邮箱:ziyu.yuan@ae-fab.com

地址: 徐高新康宁路1号高科金汇大厦A座14楼