下一代AI超算——DGX SuperPOD

在发布Blackwell GPU后,英伟达还推出了下一代AI超级计算机——由 NVIDIA GB200 Grace Blackwell 超级芯片提供支持的 NVIDIA DGX SuperPOD,用于处理万亿参数模型,并具有持续的正常运行时间,以实现超大规模生成式 AI 训练和推理工作负载。

据英伟达介绍,新型 DGX SuperPOD 采用新型高效液冷机架规模架构,采用 NVIDIA DGX™ GB200 系统构建,可在 FP4 精度下提供 11.5 exaflops 的 AI 超级计算能力和 240 TB 的快速内存,可通过额外的机架扩展到更多。

每个 DGX GB200 系统均配备 36 个 NVIDIA GB200 超级芯片,其中包括 36 个 NVIDIA Grace CPU 和 72 个 NVIDIA Blackwell GPU,通过第五代NVIDIA NVLink®连接为一台超级计算机。与 NVIDIA H100 Tensor Core GPU 相比,GB200 Superchips 对于大型语言模型推理工作负载的性能提升高达 30 倍。

NVIDIA 创始人兼首席执行官黄仁勋表示:“NVIDIA DGX AI 超级计算机是 AI 工业革命的工厂。” “新的 DGX SuperPOD 结合了 NVIDIA 加速计算、网络和软件的最新进展,使每个公司、行业和国家都能完善和生成自己的人工智能。”

下一代AI网络交换机——X800

英伟达还在演讲中发布了专为大规模人工智能而设计的新一代网络交换机 X800 系列。

英伟达表示,NVIDIA Quantum-X800 InfiniBand和 NVIDIA Spectrum-X800 Ethernet是全球首款能够实现端到端 800Gb/s 吞吐量的网络平台, 突破了计算和 AI 工作负载网络性能的界限。它们配备的软件可进一步加速各类数据中心中的人工智能、云、数据处理和 HPC 应用程序,包括那些采用新发布的基于 NVIDIA Blackwell 架构的产品系列的数据中心。

具体而言,Quantum-X800 平台包括英伟达Quantum Q3400交换机和英伟达ConnectX-8 SuperNIC,共同实现了业界领先的800Gb/s端到端吞吐量。与上一代产品相比,带宽容量提高了 5 倍,利用英伟达可扩展分级聚合和缩减协议(SHARPv4)进行的网内计算能力提高了 9 倍,达到 14.4Tflops。

Spectrum-X800平台为人工智能云和企业基础设施提供了优化的网络性能。利用SpectrumSN5600 800Gb/s交换机和英伟达BlueField-3超级网卡,Spectrum-X800平台可提供对多租户生成式人工智能云和大型企业至关重要的高级功能集。

英伟达网络高级副总裁 Gilad Shainer 表示:“NVIDIA 网络对于我们 AI 超级计算基础设施的可扩展性至关重要。” “NVIDIA X800 交换机是端到端网络平台,使我们能够实现对新 AI 基础设施至关重要的万亿参数规模的生成式 AI。”

据英伟达透露,这两款产品的目前客户包括微软Azure 和 Oracle Cloud Infrastructure。

AI助力光刻

在演讲一开始,英伟达就宣布,台积电和新思将使用英伟达的计算光刻平台即去年宣布的cuLitho 投入生产,以加速制造并突破下一代先进半导体芯片的物理极限。

计算光刻是半导体制造过程中计算最密集的工作负载,每年在 CPU 上消耗数百亿小时。芯片的典型掩模组(其生产的关键步骤)可能需要 3000 万小时或更多小时的 CPU 计算时间,因此需要在半导体代工厂内建立大型数据中心。

而英伟达称,通过加速计算,350 个 NVIDIA H100 系统现在可以取代 40,000 个 CPU 系统,加快生产时间,同时降低成本、空间和功耗。

自去年推出以来,cuLitho 为 TSMC 的创新图案化技术带来了新的机遇。在共享工作流上进行的 cuLitho 测试显示,两家公司共同将曲线流程速度和传统曼哈顿式流程速度分别提升了 45 倍和近 60 倍。这两种流程的不同点在于曲线流程的光掩模形状为曲线,而曼哈顿式流程的光掩模形状被限制为水平或垂直。

英伟达表示,自己开发了应用生成式人工智能的算法,以进一步提升cuLitho平台的价值。在通过 cuLitho 实现的加速流程的基础上,新的生成式人工智能工作流程可将速度提高 2 倍。通过应用生成式人工智能,可以创建近乎完美的反向掩膜或反向解决方案,以考虑光的衍射。然后通过传统的严格物理方法得出最终光罩,从而将整个光学近似校正(OPC)流程的速度提高了两倍。

目前,工厂工艺中的许多变化都需要对 OPC 进行修改,从而增加了所需的计算量,并在工厂开发周期中造成了瓶颈。cuLitho 提供的加速计算和生成式人工智能可减轻这些成本和瓶颈,使工厂能够分配可用的计算能力和工程带宽,在开发 2 纳米及更先进的新技术时设计出更多新颖的解决方案。

TSMC 首席执行官魏哲家博士表示:“通过与 NVIDIA 一同将 GPU 加速计算整合到 TSMC 的工作流中,我们大幅提升了性能、增加了吞吐量、缩短了周期时间并减少了功耗。TSMC 正在将NVIDIA cuLitho 投入到生产中,利用这项计算光刻技术推动关键的半导体微缩环节。

Synopsys 总裁兼首席执行官 Sassine Ghazi 表示:“二十多年来,Synopsys Proteus 光掩模合成软件产品一直是经过生产验证的首选加速计算光刻技术,而计算光刻是半导体制造中要求最严苛的工作负载。发展至先进的制造工艺后,计算光刻的复杂性和计算成本都急剧增加。通过与 TSMC 和 NVIDIA 合作,我们开创了能够运用加速计算的力量将周转时间缩短若干数量级的先进技术,因此这一合作对于实现埃米级微缩至关重要。”

随着EDA厂商新思将该技术集成到其软件工具中,以及代工龙头台积电的应用,计算光刻未来前景广阔,可能会被更多芯片厂商所采用。

依旧遥遥领先

B200的推出,延续了H100之后英伟达的GPU霸权,就目前来说,依旧没有公司能够撼动它的地位,这是它过去深耕十年应有的回报。

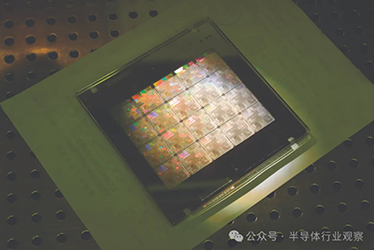

但你可以注意到一个小细节,英伟达终于放弃了单体芯片设计,而是转向多芯片设计,原因也很简单,B200采用的是台积电改进版的N4P工艺,在晶体管密度上没有大幅升级,而H100已经是一个全掩模版尺寸的芯片——它的芯片尺寸为 814 mm2,理论最大值为 858 mm2,在这样的情况下,转向双芯片似乎并不难理解。

此外,英伟达也不再满足于销售单个芯片,而是兜售一整个系统,也就是英伟达 B200 NVL72,包含 600000 个零件,重1361 公斤的它,可能会成为AI企业的新宠儿。

可以说,英伟达已经靠B200牢牢吸住了AI产业下一年的金,依旧是这一领域中毫无争议的王。

文章来源:半导体行业观察

联系人:袁经理

手机:051683539599

电话:051683539599

邮箱:ziyu.yuan@ae-fab.com

地址: 徐高新康宁路1号高科金汇大厦A座14楼